Commission Technique : compte-rendu de la réunion du 12 novembre 2025

La réunion démarre à 17:00. Elle s’est déroulée en présence dans les locaux de la FICAM à Paris 16e, et simultanément en visioconférence, avec la participation de :

| Jean-Baptiste | BABIN | Backup Media Group | CEO |

| Béatrice | BAUWENS | MPC | Directrice Post&VFX Paris |

| Mélanie | BENAZETH | IMAGINE Editions | Responsable technique |

| Pierre-Marie | BOYÉ | Les Tontons Truqueurs | Directeur des Productions |

| Xavier | BRACHET | MADN | CEO / Founder |

| Marie-Charlotte | DE VILLELONGUE | IMAGINE Editions | Responsable service sous-titrage |

| Jean-Charles | DUGUÉ | Groupe CINEKITA | Exploitation – Vérification |

| Frédéric | FERMON | CST | Chargé de mission – Immersion & Temps Réel |

| Patrick | GOESSANT | M141 | Directeur Technique |

| Laurent | HERITIER | Transpa | Directeur d’Exploitation |

| Pierre | JACQUET | TITRAFILM | Directeur Technique |

| Madeleine | KOUADIO-TIMMERMAN | Groupe CINEKITA | Responsable de Cinekita France, Côte d’Ivoire |

| Adrien | LEDOUX | Groupe CINEKITA | Business Developer |

| Benoit | MAUJEAN | FICAM | Délégué Adjoint Technologies |

| Hugues | NAMUR | MPC | Superviseur VFX |

| Alexis | OBLET | The Yard | CTO |

| Florian | STÈGRE | CHECKSUB | Fondateur |

Ordre du jour

- Retour sur SATIS 2025

- Présentation de Checksub par Florian STÈGRE

- Questions Diverses

1- Retour sur SATIS 2025

(par Benoit MAUJEAN – FICAM)

Liens vers les slides de la présentation

Le SATIS, organisé par Stéphan FAUDEUX (Génération Numérique), s’est tenu les 5 et 6 novembre aux Docks de Paris, Saint-Denis. C’est le rendez-vous annuel des professionnels de l’audiovisuel. Il a réuni cet année plus de 9.000 participants, dont 200 exposants et plus de 70 conférences, keynotes et tables rondes.

https://satis-expo.com/fr/satis-2025

Ci-dessous, une sélection de quelques conférences.

Journée CST

Une journée de tables rondes était organisée par le département Broadcast de la CST.

Vers une harmonisation des livrables UHD HDR : avec Pierre Maillat de Canal+, Tania Pouli de VividManta et Victorien Giret pour France TV.

La CST, aux côtés des diffuseurs (M6, France Télévisions, TF1, Arte, Canal+) et de la FICAM, travaille à l’élaboration d’un cadre commun pour les livraisons PAD adaptés à l’UHD et au HDR. Plutôt qu’un format unique, complexe à mettre en oeuvre face aux variations de résolution, de fréquence d’images ou d’encodage HDR, l’objectif est d’établir des guidelines et bonnes pratiques, tout en anticipant les conversions entre les flux SDR et HDR notamment. L’occasion aussi pour la CST de sortir un glossaire pédagogique pour démystifier le HDR : pas seulement pas seulement un recueil de définitions mais aussi un guide pour mieux comprendre les concepts du HDR.

ST 2110-43 et les défis de son intégration dans un contexte Broadcast : recommandations du groupe de travail concernant les sous-titrages, avec Emanuele Di Mauro de l’IIFA-Media 180, Caroline Touzé de TV5 Monde, Bruno Plouvier de RedBee Media et Guillaume Arthuis de BBright.

La norme ST 2110-43, dédiée au transport de sous-titres en IP via le format TTML (Timed Text Markup Language), ouvre de nouvelles perspectives pour l’interopérabilité dans les chaînes de production audiovisuelle notamment pour le streaming. Cependant, la portée très générale du TTML et le manque de précisions sur plusieurs aspects critiques rendent son intégration complexe dans un environnement Broadcast.

Cette conférence propose un éclairage sur les intentions de la norme, en précisant les zones d’ambiguïté rencontrées lors des premières implémentations.

L’IPMX: le 2110 rendu facile ? : avec Christophe Almeras de Panasonic, Jean-Paul Grall de de l’IIFA-Media 180, Cyril Mazouer de BOB.

L’IPMX n’est pas vraiment un nouveau format de transport AV sur IP — il repose sur la norme bien connue ST 2110. Mais il se distingue par une approche pensée pour simplifier le déploiement dans les marchés Événementiel, Corporate et Broadcast (compatibilité matériel informatique HDMI, pour les écrans, les projecteurs, les murs LEDs) avec notamment les problèmes liés à la synchro d’horloge (PTP).

Du local au virtuel : penser la chaîne Broadcast dans le Cloud : avec Emanuele Di Mauro de l’IIFA-Media 180, Jean-Luc Liaud d’Harmonic et Eric Dufosse de EDConsulting.

Comment adapter la configuration des serveurs virtuels (RAM, processeurs, disques) en fonction des services attendus sur la défintion, le contrôle et la distribution des médias avec la virtualisation des réseaux et des infrastructures, à travers les IaaS, PaaS et SaaS.

Illusions numériques : quels outils contre les dérives de la génération vidéo par lA : avec Gaëtan Le Guelvouitg d’Imatag, Mathieu Desoubeaux d’Imatag et François-Xavier Marit de l’AFP.

La désinformation repose souvent sur des contenus falsifiés ou décontextualisés. Le C2PA (Coalition for Content Provenance and Authenticity) cherche à apporter des preuves d’origine et d’intégrité aux médias numériques avec des Signatures vérifiables et métadonnées standardisées. Mais ces métadonnées sont simples à supprimer, même sans le vouloir et il impose un écosystème de bout en bout. Le soft binding par watermark corrige le problème. C’est une étape majeure vers un écosystème numérique de confiance, où chaque image, vidéo ou son peut être authentifié à la source.

Cap Innovation @SATIS par Cap Digital

Une journée et demie de tables rondes était organisée par Cap Digital pour parler d’innovation dans les industries culturelles et créatives.

Accompagnement des projets d’innovation collaborative impliquant des labos et le transfert de technologie : avec Loubna Sallak de Cap Digital, Pauline Dalmasso du CNC, Delphine Gilges-Crampont de l’Institut Carnot M.I.N.E.S et Adrien Bourdin du CNRS.

Les bonnes paratiques pour monter et financer des projets collaboratifs pour nos industries avec des labos de recherche.

Panorama de la recherche à l’INRIA : avec Stéphane Donikian de l’INRIA

L’INRIA compte plus de 30 partenaires dans les ICC : certains ont donné la naissance à une 10aine de stratups (4DViews, Golaem, …).

Stéphane DONIKIAN dresse un panorama de ces partenariats avec les industries culturelles et créatives, en présentant les résultats de 8 équipes de recherche, notamment avec des technologies comme l’animation 3D de personnages, le 3DGS, les shaders de rendu 3D, l’animation 2D, Speech to Text ou Text to Speech, l’IA générative, la SuperRésolution ou le HDR.

Les grandes tendances de la recherche dans le domaine de l’audiovisuel et l’IA : avec Marc Bourhis de Cap Digital, Rémy Sohier de Univ. Paris 8, Benoit Maujean de la Ficam et Stéphane Donikian de l’INRIA.

Mise en lumière des pistes concrètes pour intégrer l’IA dans la chaîne de création: évolution des pipelines de fabrication, formation et pédagogie, expériences métiers en lien avec l’open source comme enjeu de compétitivité, de transparence et de traçabilité.

3D Gaussian Splat pour des simulations immersives et interactives en XR (industrie, patrimoine, etc.) : avec Gilles Rougeron du CEA List.

Le Laboratoire de Simulation Interactive (LSI) développe une plateforme de simulation multi-physique exploitant la réalité virtuelle et mixte. Sa chaîne logicielle 3DGStudio, basée sur le 3D Gaussian Splatting, couvre l’ensemble du pipeline : de la captation à la scénarisation XR, en passant par l’entraînement, l’édition et le nettoyage des données. La présentation présente cette technologie, et l’illustre par des cas d’usage dans l’automobile, l’audiovisuel, le design et le patrimoine, avant d’aborder les perspectives en matière de captation, d’édition de scènes et d’enrichissement du rendu immersif.

La Table de Montage Spatial par Rémi Sagot-Duvauroux de l’ENSAD.

Comment penser le montage à l’ère de la XR ? Ce dispositif de recherche-création en réalité virtuelle permet aux artistes de concevoir et tester leurs œuvres immersives en anticipant les comportements des spectateurs. Pensé comme une maquette interactive, il offre la possibilité de manipuler en temps réel décors, personnages, lumières et sons, tout en définissant les zones explorables de l’espace scénique. Grâce à un changement d’échelle fluide, l’artiste peut alterner entre le point de vue du créateur et celui du spectateur afin d’expérimenter la mise en scène, le montage et la structure spatio-temporelle de son récit. Inspiré des pratiques du cinéma, ce dispositif explore de nouvelles manières de concevoir la narration et l’interactivité en réalité virtuelle.

Présentation du Master “Extended Cinematography” (XCin) de l’École Polytechnique & l’ENS Louis Lumière par Pascal Guehl.

Comment former les créateurs aux nouveaux territoires de l’image en mouvement ?

Le Master “Extended Cinematography”, co-porté par l’École Polytechnique et l’ENS Louis-Lumière, explore les mutations de la cinématographie à l’ère des images générées, étendues, immersives : un programme de recherche et de formation à la croisée des sciences, de la technique et de l’art.

Présentation de l’Isart Digital Lab par Jean-Francois Ramos de l’Isart Digital Lab et Cédric Bonin de SEPPIA.

Jean-François Ramos (Isart Digital Paris), collabore avec le producteur Cédric Bonin (SEPPIA) sur un documentaire, coproduit par Arte, sur la vie de Machiavel – l’art de la politique, en tirant parti d’un workflow hybride mélangeant IA Générative et outil de compositing traditonnel (Nuke), avec des contraintes de production réelle.

Présentation du projet R&D Tamed Cloud par

François Garnier de l’ENSAD.

Tamed Cloud est une expérience immersive en réalité virtuelle qui propose une nouvelle façon d’explorer des ensembles massifs de données, représentés sous la forme d’un nuage interactif, organique et évolutif. Ce dispositif innovant mêle interaction gestuelle, posturale et vocale pour transformer notre rapport aux données numériques et ouvrir de nouvelles perspectives dans les champs de la création, de la médiation ou encore de la recherche.

Présentation du projet d’identification des contenus générés par lA par

Mihai Mitra de l’IP Paris.

Mihai Mitrea présente un projet innovant dédié à l’identification automatique des contenus générés par l’intelligence artificielle. Un enjeu majeur pour la fiabilité de l’information et la lutte contre la désinformation. Le watermarking lors de l’entraînement permet d’identifier le créateur initial du modèle, tandis qu’un watermark post-training peut tracer la revente ou le transfert à un utilisateur final. Les tests montrent que la marque résiste plusieurs cycles de fine-tuning, ce qui décourage les tentatives d’effacement. Le watermarking a aussi une fonction d’anti-manipulation, empêchant les suppressions malveillantes de métadonnées (comme dans le cas des tampons C2PA).

Présentation du projet R&D collaboratif MedIAdata par Renan Mouren de l’INSA HdF, Cédric Lejeune de Holli et Emmanuel Delamarre de EuraCreative.

Le projet MedIAdata explore les synergies entre intelligence artificielle, données et création audiovisuelle pour fluidifier la gestion des données tout au long du processus créatif des studios d’animation des Hauts-de-France. Né d’une collaboration entre chercheurs, ingénieurs et acteurs du secteur culturel, il vise à développer de nouveaux outils et méthodes d’analyse pour enrichir la production et la valorisation des contenus médias.

Présence du WAIFF

Le WAIFF Festival, dédié au cinéma créé avec l’IA, fait sa première apparition au SATIS.

Lors de sa 1ère édition 2025 à Cannes, 1500 films ont été reçus, 25 sélectionnés et 11 prix décernés dont un grand prix de 10 000 €. Les films doivent utiliser au moins 3 outils d’IA générative et être fournis en HD/4K avec un journal de production.

Au SATIS 2025 : espace de projection dédié, avant-première du trailer 2026 et conférence sur les nouveaux marchés de la création IA.

Prochain rendez-vous à Cannes les 21-22 avril 2026.

https://worldaifilmfestival.com/

https://worldaifilmfestival.com/rules/

Autres conférences

Making of des effets visuels de “L’Homme qui rétrécit” de Jan Kounen par Mac Guf (Rodolphe Chabrier et Benoit de Longlée) et Spline (Romain Bourzeix).

– Plus de 300 plans traqués directement sur le plateau, sans marqueur

– Réutilisation des trajectoires caméra à échelle réduite, dans le décor réel, à l’aide du motion control.

Voir article Mediakwest et post de Spline

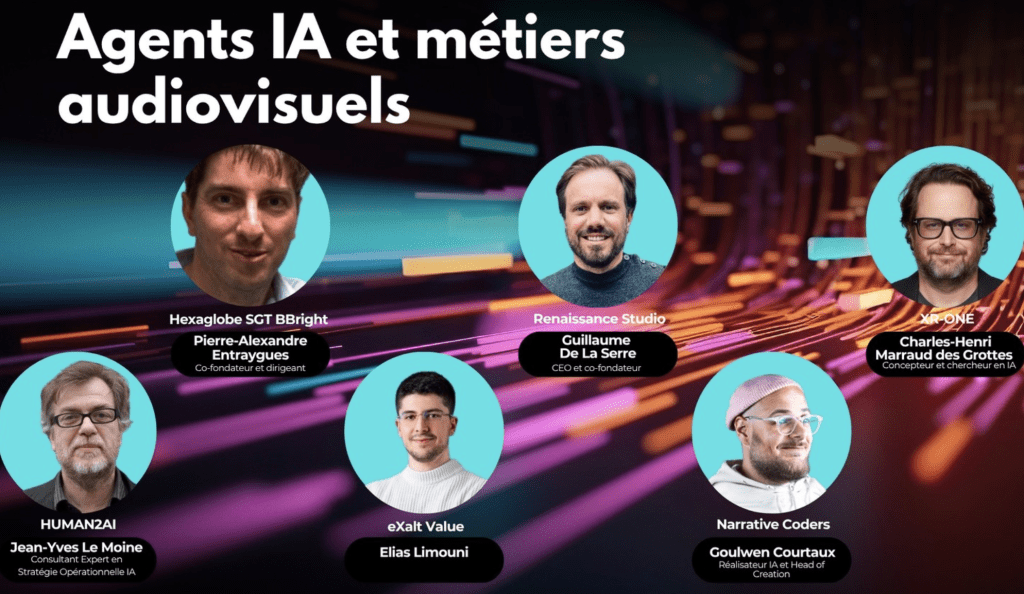

Agents IA et métiers audiovisuels par Jean-Yves Le Moine de Human2AI, Elias Limouni de eXaltValue, Goulwen Courtaux de Narrative Coders, Guillaume de la Serre de Renaissance Studio, Pierre-Alexandre Entraygues de Hexaglobe SGT BBright et Charles-Henri Marraud des Grottes de XR One.

L’émergence des agents intelligents marque un tournant dans la transformation des métiers de l’audiovisuel. De l’automatisation du casting à la gestion de projet, en passant par la recommandation créative et la prévisualisation intelligente, l’IA s’infiltre dans toutes les étapes de la production. Quels métiers seront augmentés, repensés, ou remplacés ? Va-t-on vers une réorganisation des compétences autour de tâches plus stratégiques ? Cette mutation annonce-t-elle l’avènement d’un nouveau modèle hybride, où chaque professionnel travaillerait en tandem avec un assistant virtuel ou “jumeau numérique” dédié à l’optimisation de ses tâches quotidiennes ?

Animation et IA par Jean-Yves Le Moine de Human2AI, Aton Soumache de The Magical Society, Stanislas Mako de Blue Spirit Studios, Grégory Allain de Alpha Z Production, Pierre Tessier de Wazza Studios et Olivia Papini de Tokyo Epic

L’intelligence artificielle révolutionne les processus de création en animation, en intervenant à toutes les étapes : génération automatisée des mouvements, synchronisation labiale précise, conception rapide de personnages stylisés… Ces outils transforment en profondeur les méthodes de production et ouvrent de nouvelles perspectives esthétiques. L’animation devient un véritable terrain d’expérimentation pour l’IA : pipelines de production ultra-accélérés, liberté créative décuplée, émergence de nouveaux modèles pour les créateurs indépendants et micro-équipes. Cette mutation interroge aussi : l’animation sera-t-elle la première discipline à tirer pleinement parti du potentiel de l’IA, quitte à redéfinir ses propres fondamentaux ?

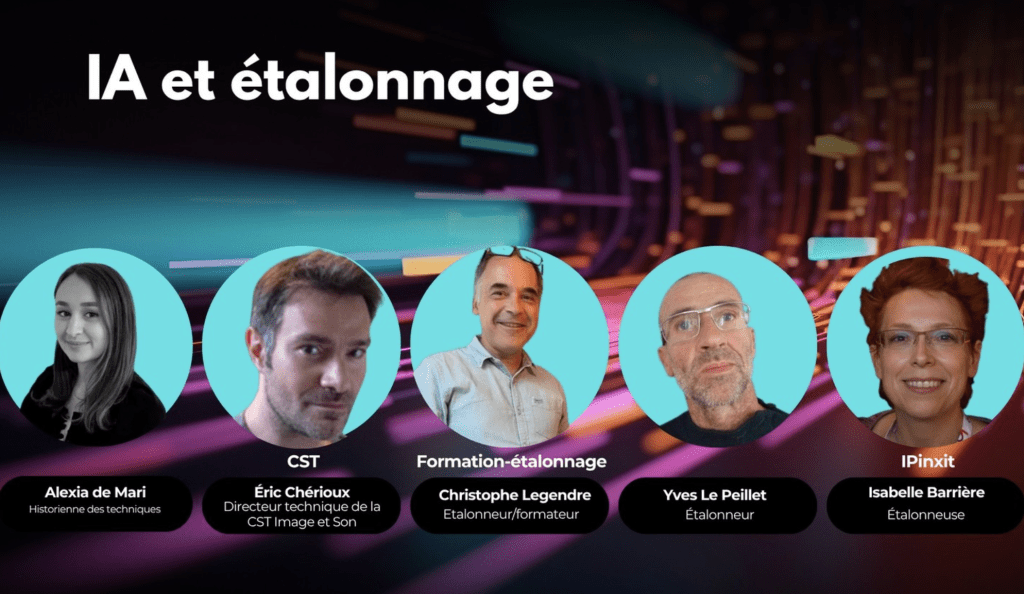

IA et Étalonnage par Alexia de Mari, Eric Chérioux de la CST, Chritophe Legendre (étalonneur formateur), Yves Le Peillet (étalonneur) et Isabelle Barrière (étalonneuse).

L’intégration progressive de l’intelligence artificielle dans les logiciels d’étalonnage bouleverse les pratiques professionnelles du secteur.

Automatisation des tâches, gain de temps, amélioration de la qualité d’image ou encore standardisation des rendus : quels bénéfices réels ces technologies apportent-elles, et où en sont leurs limites ?

Cette table ronde dresse un panorama des solutions disponibles, s’appuie sur des retours d’expérience concrets et ouvre une réflexion sur les impacts à court et long terme de ces outils sur le métier.

Virtual Production: du laboratoire à l’industrie profitable par Stephan Faudeux, Anna Doublet (Sony), Bruno Corsini (Prodigious), Pierre-Marie Boyé (Les Tontons Truqueurs) et Patrick Jeant (Yewth).

En 2025, la production virtuelle atteint une maturité technologique sans précédent. Mais comment la rendre rentable, accessible, et durable ? Avec des enjeux comme la standardisation des workflows, l’IA, les LED walls, la formation, l’impact environnemental…

Produire en 8K et plus pour des espaces et casques immersifs par Bernard Mendiburu (Digital Rise), Frank-David Cohen(Immersive Flashback), Alexandre Regeffe (RShift) et Aristote Douroudakis (Flow Dreams & Stories).

Produire en 8K, 12K ou plus n’est plus une expérimentation, mais une réalité pour les espaces immersifs, dômes, studios virtuels ou casques XR.

Décryptage des nouveaux défis techniques et standards de diffusion qui façonnent l’avenir des contenus immersifs (captation, rendus pré-calculés ou temps réel, formats compatibles et retours terrain sur les workflows de production à très haute résolution).

Monétisation et Contrats : Sécuriser ses droits et revenus par Lucie Walker (avocate), Ros Agodjro (SACD), Pierre Nouailhac (Propulse) et Saïda Chouddane (Pandora Création).

La monétisation des contenus passe avant tout par une bonne maîtrise des contrats ; qu’ils soient conclus avec des marques, des diffuseurs ou des plateformes. Il est essentiel de comprendre et de négocier les clauses clés : exclusivité, cession de droits, durée d’exploitation, conditions de rémunération… Autant d’éléments qui peuvent avoir un impact direct sur vos revenus à court et long terme. En complément, le financement participatif représente une source de revenus alternative intéressante, à condition d’en maîtriser le cadre légal et les obligations déclaratives. Enfin, il ne faut pas négliger les aspects fiscaux et administratifs : TVA, impôt sur les sociétés ou sur le revenu, cotisations… Ces éléments, souvent mal anticipés, sont pourtant essentiels pour assurer la pérennité et la conformité de votre activité.

VFX : Comment bâtir une économie durable ? par Alexia de Mari, David Danesi (Digital District), Arnaud Roland (CNC), Morgane Le Gallic (Tanuki Post-Prod), Réjane Halus-Vallée (Maitresse de conf.) et Béatrice Bauwens (MPC).

Alors que les investissements ne cessent de croître en France, l’industrie peine encore à consolider des modèles économiques pérennes. Plusieurs studios font face à des difficultés structurelles, malgré une montée en compétences remarquable des professionnels et le développement soutenu de formations spécialisées.

Etat des lieux du secteur des VFX, en analysant les facteurs d’instabilité actuels (pression concurrentielle, dépendance aux appels d’offres, temporalité des projets) et en identifiant les leviers possibles comme l’innovation, avec des soutiens comme celui du CNC.

C’est quoi un doublage réussi ? par Benoit Stefani (ingénieur du son), Miguel Adélise (44.1), Olivia Luccioni (Dir. Artistique, comédienne voix), Jérôme Malaize (Dubbing Brothers) et Anne Mathot (Dir. Artistique, comédienne voix).

À l’heure où les plateformes nous offrent une grande liberté de choix linguistique, qu’est-ce qui nous pousse, au moment de sélectionner une piste audio, à préférer la version française à la version originale ? Quels sont les critères qui nous font juger qu’un doublage est réussi : la justesse de l’interprétation ? L’adéquation voix/personnage ? La qualité de l’adaptation des dialogues ? Ces questions, loin d’être anecdotiques, prennent une nouvelle dimension à l’ère de l’intelligence artificielle générative, qui commence à s’immiscer dans les processus de traduction, de doublage, voire de re-synchronisation vocale. Dans un contexte de mutation rapide de l’industrie audiovisuelle, il devient essentiel de réinterroger notre rapport aux langues, aux voix et à l’authenticité, pour mieux comprendre ce qui fait la valeur (humaine, artistique et culturelle) d’un doublage réussi.

A propos de l’influence grandissante de l’IA dans nos métiers, Laurent Héritier a signalé l’importance qu’il a été accordé à ce sujet lors des Rencontres Cinématographiques de l’ARP. Il tient aussi à souligner qu’on oublie souvent de mentionner la problématique de l’empreinte carbone des solutions fournies par l’IA.

Benoit Maujean invite les participants à suivre le projet MedIAdata initié par Renan Mouren, Cédric Lejeune et Emmanuel Delamarre de EuraCreative (pas de doc en ligne pour l’instant). Il rappelle aussi que Mistral a publié cet été avec le bilan carbone de leur solution, en collaboration avec l’agence Carbone 4 et l’ADEME.

L’autre problématique de fond avec les outils d’IA est la gestion de la propriété intellectuelle, avec notamment les efforts du Parlement EU pour proposer un cadre légal de régulation et de rémunération des ayants-droits. Voir à ce sujet le replay de la table ronde de l’ARP Régulations et droits d’auteur animé par Juliette PRISSARD (EUROCINEMA) et Elsa BENNETT (Cinéaste de l’ARP), avec David CORMAND et Axel VOSS (députés EU) , Jean-Philippe MOCHON (CSPLA), Pauline AUGRAIN (CNC), Antoine BOILLEY (ARCOM), Héloise FONTANEL (SACEM) et Idzard VAN DER PUYL (PROCIREP).

Plus d’informations sur le SATIS 2025 ici :

– l’article de Mediakwest

– le SATIS sur Linkedin

– la chaine SATIS TV, où l’on retrouvera en décembre le replay des conférences (à suivre)

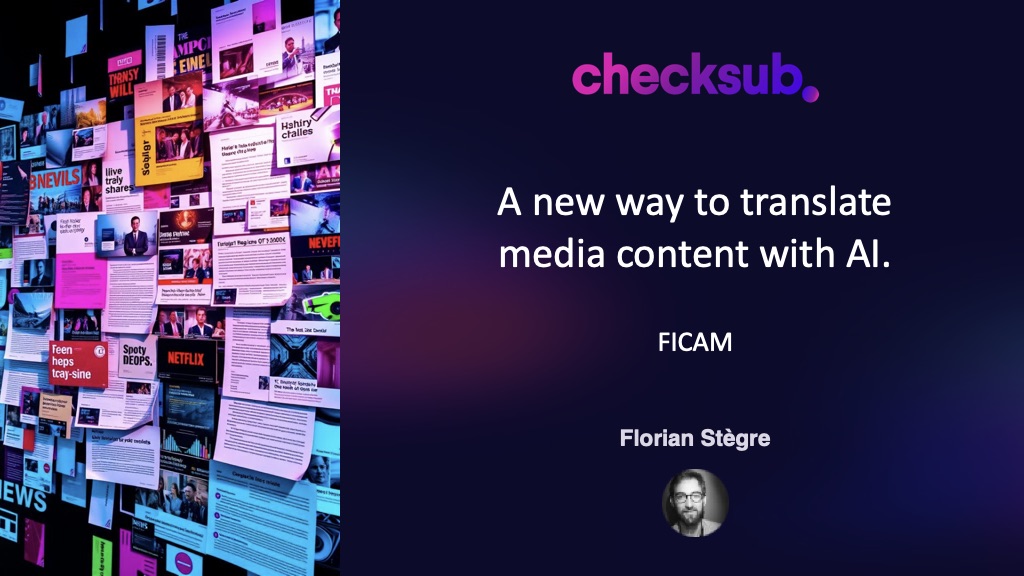

2- Checksub

(par Florian STÈGRE)

Lien vers les slides de la présentation de Florian (PDF) – les videos sont présentées à part.

Fondée en 2017, Checksub améliore la qualité et la rapidité du sous-titrage, doublage et voice-over en combinant IA et contrôle humain. La plateforme intègre la reconnaissance vocale, la synchronisation labiale et l’adaptation linguistique. Un éditeur avancé avec une timeline permet de faire des corrections, d’ajouter du vocabulaire personnalisé et de vérifier automatiquement la conformité à certaines règles personnalisables, comme le remplacement de mots grossiers, des chiffres sous formes de lettres, l’insertion de sauts minimums entre les changements de plans, etc… La solution offre un workflow complet incluant transcription automatique, relecture assistée, adaptation contextuelle et traduction multilingue.

Interview AWS v1 Short-2785.mov (en jaune, traduction automatique faite par Checksub)

Interview AWS v2 short-2784.mov (idem, après ajout de vocabulaire spécifique).

L’entreprise a développé son propre moteur de synthèse vocale “Odub” pour maîtriser les aspects légaux et techniques, déployable on-premise ou en cloud privé. Elle propose deux approches : le doublage automatique pour des projets simples et le voice-morphing à partir de voix humaines enregistrées, pour des projets nécessitant une qualité supérieure ou à budgets limités (films corporates d’un côté, documentaires non-premium de l’autre). Des limites techniques sont encore constatées dans la qualité du doublage full automatique, surtout pour des dialogues avec des émotions complexes, des croisements de dialogue (overlapping), ou des nuances contextuelles. D’où l’importance d’une supervision humaine dans des workflows hybrides (et le recours au voice morphing), car la technologie n’est pas encore mature pour un remplacement total par le seul logiciel.

La demande croissante pour des solutions optimisées s’explique notamment par la pression tarifaire exercée par des concurrents africains et luxembourgeois qui proposent des prestations tout-en-un à des tarifs très agressifs.

Exemple d’AI dubbing par Checksub

Original video Scarlette-1465.mov (video d’origine)

Bad example Dubbing Scarlette-1463.mov (exemple où le doublage automatique est en échec).

Adrien et Jean-Charles de Cinekita ont demandé s’il était possible de paramétrer la vitesse de lecture du film pour s’adapter aux fréquences du type 23,98 ou 29,97 ou 59.94 (pour des films américains). Florian répond que pour l’instant la détection est automatique, sans de retours clients à ce sujet, mais qu’il serait possible de rajouter ce paramètre dans les settings du projet.

Les enjeux clés avec l’IA sont la gestion rigoureuse des droits d’auteur et le consentement pour l’utilisation des voix dans l’entraînement des logiciels. Des datasets vocaux basés sur des autorisations contractuelles offrent la perspective d’un système de rémunération qui pourrait être récurrente et surtout de se positionner face à la domination américaine des modèles actuels. Checksub défend l’émergence d’un modèle d’IA européen, avec une empreinte carbone maîtrisée et respectueux des droits d’auteurs ou droits voisins. Un travail de sensibilisation et d’accompagnement est nécessaire en France auprès des acteurs traditionnels (studios, comédiens,…) notamment pour les aider à mieux comprendre les workflows associés à ces outils semi-automatiques et les modèles d’affaires qui pourraient émerger. Certaines solutions ont nui à la perception des outils d’IA en proposant des solutions entièrement automatisées dont les résultats se sont révélés décevants.

Checksub ne se positionne pas en prestataire de services, mais comme apporteur de technologie. La nuance est cependant en train de s’estomper avec le déploiement de solution en mode Software As A Service et la plateformisation des contenus (voir nos échanges à ce sujet dans le compte-rendu IBC avec l’émergence de workflows automatisés pour la génération et la conformation des medias sur les différents canaux de distribution). Et Florian S. nous signale même que certains acteurs américains – soutenus par des fonds d’investissements ambitieux, vont se positionner comme de nouveaux concurrents avec une approche “full stack” dont les process vont s’appuyer sur l’IA pour court-circuiter les maillons traditionnels de la chaîne de valeur (pas seulement dans les industries créatives, mais également dans le secteur juridique par exemple).

3 – Autres événements et informations

👉 Appel à candidatures pour les César & Techniques 2026.

Vous avez jusqu’au 28 novembre 2025 minuit pour être candidat:

– au Trophée César & Techniques 2026

– au Prix de l’innovation César & Techniques 2026.

Renseignements :

https://www.academie-cinema.org/evenements/cesar-techniques-2026/

Dossier à renvoyer par mail : stephane.bedin@ficam.fr

👉 Afterwork Open Source, organisé par Cap Digital, la CST et la FICAM, Mardi 9 décembre à 18:00, chez Cap Digital.

Une soirée pour échanger, apprendre et partager autour de l’Open Source !

Sur inscription : https://cst.fr/open-source-after-work/

👉 Ouverture à la consultation publique

de la recommandation technique CST-RT-011 révisée :

“Ergonomie des studios de tournage d’œuvre de fiction”.

Avant le 17 décembre prochain

https://cst.fr/consultation-rt-011/

Sans oublier les Newsletters hebdomadaire et mensuelle de la FICAM

La réunion s’achève à 19:00.